Fecha: 29 de febrero de 2024

Fecha: 29 de febrero de 2024

Lugar: Sede de la revista Temas

Lugar: Sede de la revista Temas

Fecha: 29 de febrero de 2024

Fecha: 29 de febrero de 2024

Lugar: Sede de la revista Temas

Lugar: Sede de la revista Temas

Moderador:

Moderador: ¿De qué socialismo estamos hablando? - 27 de noviembre de 2025

¿De qué socialismo estamos hablando? - 27 de noviembre de 2025 Sal de la democracia: política y participación - 30 de octubre de 2025

Sal de la democracia: política y participación - 30 de octubre de 2025 Debatiendo ideas en el cine [Centenario de A. Guevara] - 25 de septiembre de 2025

Debatiendo ideas en el cine [Centenario de A. Guevara] - 25 de septiembre de 2025 Entre las desigualdades y la movilidad social - 24 de julio de 2025

Entre las desigualdades y la movilidad social - 24 de julio de 2025 El agua por todas partes: sustentabilidad y políticas del clima - 26 de junio de 2025

El agua por todas partes: sustentabilidad y políticas del clima - 26 de junio de 2025 Más salud: higiene, hábitat y equidad - 29 de mayo de 2025

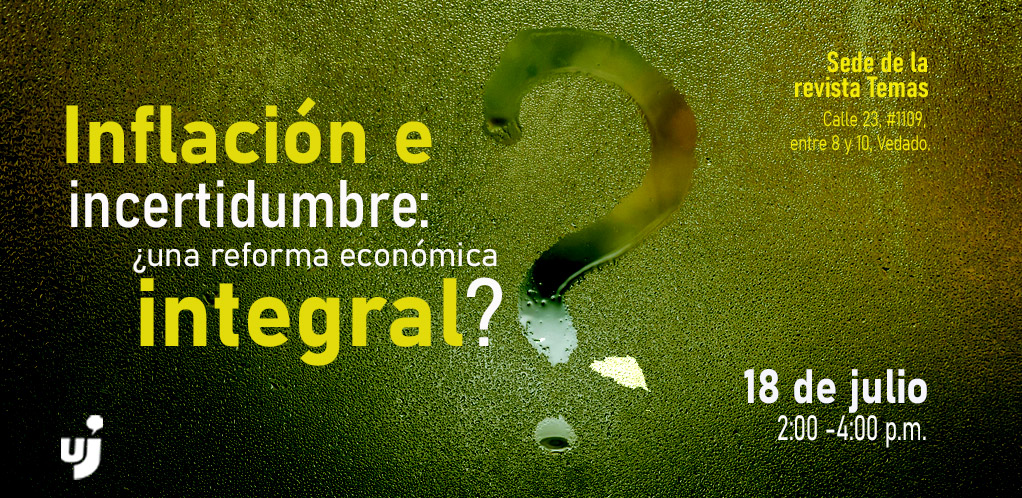

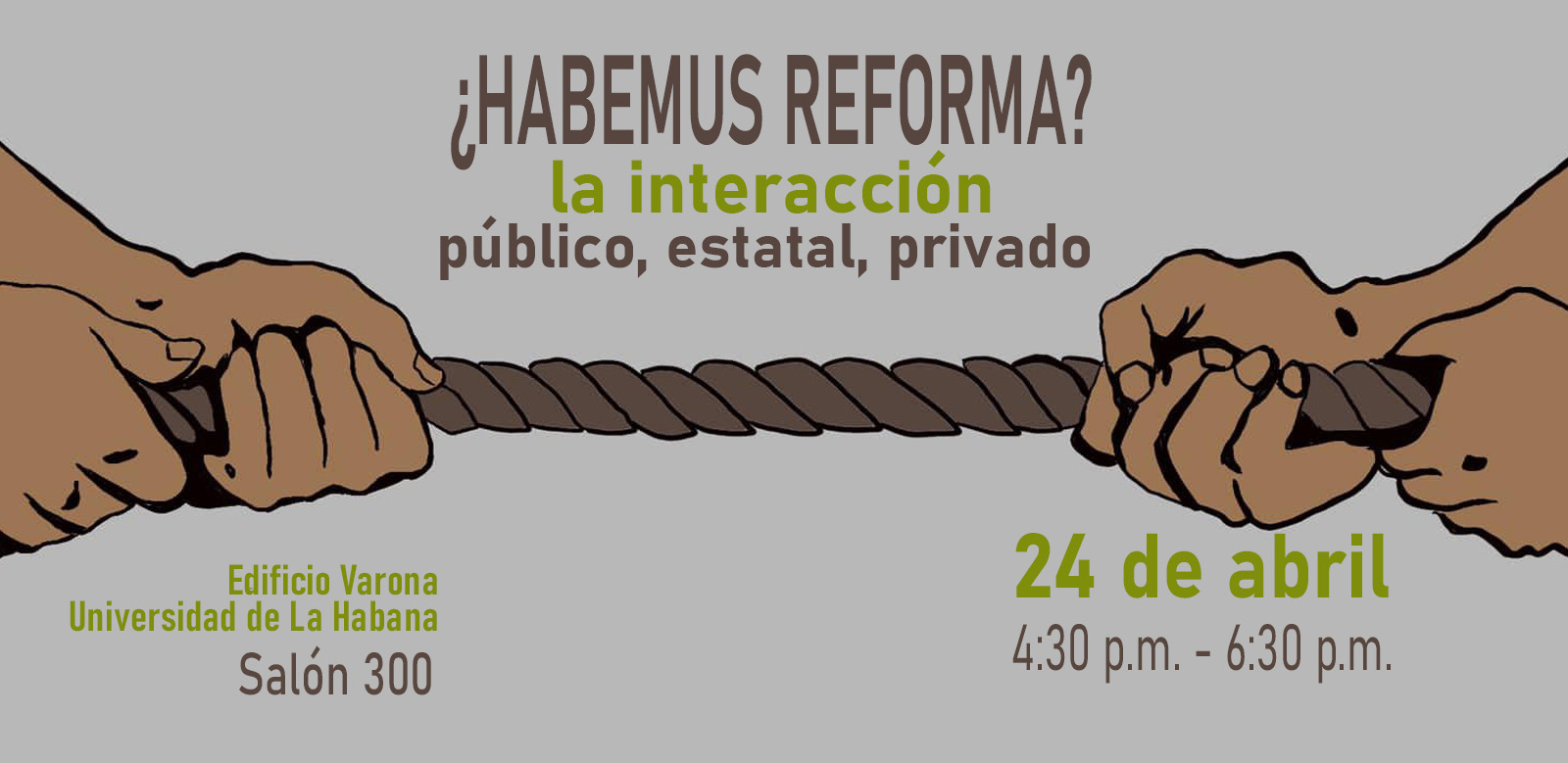

Más salud: higiene, hábitat y equidad - 29 de mayo de 2025 ¿Habemus reformas? La interacción público, estatal, privado - 24 de abril de 2025

¿Habemus reformas? La interacción público, estatal, privado - 24 de abril de 2025 "Discapacitados" nuestros de cada día - 27 de marzo de 2025

"Discapacitados" nuestros de cada día - 27 de marzo de 2025 Reconfiguraciones geopolíticas y conflictos internacionales - 27 de febrero de 2025

Reconfiguraciones geopolíticas y conflictos internacionales - 27 de febrero de 2025 El reparto: música popular y polémica social - 30 de enero de 2025

El reparto: música popular y polémica social - 30 de enero de 2025 Policrisis cubana: dimensión y perspectivas - 26 de noviembre de 2026

Policrisis cubana: dimensión y perspectivas - 26 de noviembre de 2026 Clases sociales, desigualdades y pobreza en Cuba - 29 de octubre de 2026

Clases sociales, desigualdades y pobreza en Cuba - 29 de octubre de 2026 La ANPP en la política cubana - 24 de septiembre de 2026

La ANPP en la política cubana - 24 de septiembre de 2026 Un socialismo con características chinas: el modelo y el orden mundial - 23 de julio de 2026

Un socialismo con características chinas: el modelo y el orden mundial - 23 de julio de 2026 Partiendo los nudos de la política económica: las alternativas - 25 de junio de 2026

Partiendo los nudos de la política económica: las alternativas - 25 de junio de 2026 ¿De qué socialismo estamos hablando? - 28 de mayo de 2026

¿De qué socialismo estamos hablando? - 28 de mayo de 2026 Caminando hacia una reforma de la educación - 30 de abril de 2026

Caminando hacia una reforma de la educación - 30 de abril de 2026 Mercado, dolarización y costo de la vida desde la(s) economía(s) familiar(es) - 26 de marzo de 2026

Mercado, dolarización y costo de la vida desde la(s) economía(s) familiar(es) - 26 de marzo de 2026 El sistema de salud: lo intocable y lo que apremia - 26 de febrero de 2026

El sistema de salud: lo intocable y lo que apremia - 26 de febrero de 2026 Cuba en el mundo: continuidad y ajustes en las relaciones internacionales - 29 de enero de 2026

Cuba en el mundo: continuidad y ajustes en las relaciones internacionales - 29 de enero de 2026